近年、AIを身近に体験できるサービスやアプリケーションなどが次々と登場していますが、多くは強力な処理性能を備えたサーバー経由で使用できるオンラインサービスとなっています。しかし、これらに頼らず自前のPCでAIを使う際にどのGPUが最適なのか、まとめたベンチマーク結果がTom's Hardwareが調査をしその結果を発表しています。

Stable Diffusionを用いてGPUのAI処理性能をベンチマーク。NVIDIA製GPUが最適解

AIサービスと言うと最近ではChatGPTと呼ばれるサービスが話題を集めていますが、その前にAIがユーザーが入力したキーワードを基に画像を出力するStable Diffusionが話題となっていました。

これらのAIサービスは基本的に強力な処理性能を備えたサーバーで処理が行われるオンラインサービスとなっていますが、Stable Diffusionに関してはある程度強力なグラフィックカードを使えば自前でも画像の出力が可能になっています。

今回、このStable Diffusionの処理について、NVIDIAやAMD、Intel製の最新グラフィックカードの中から最適なモデルはどれか参考とするためTom's Hardwareがベンチマークを行い、その結果を掲載しています。

Stable Diffusion Benchmarked: Which GPU Runs AI Fastest | Tom's Hardware

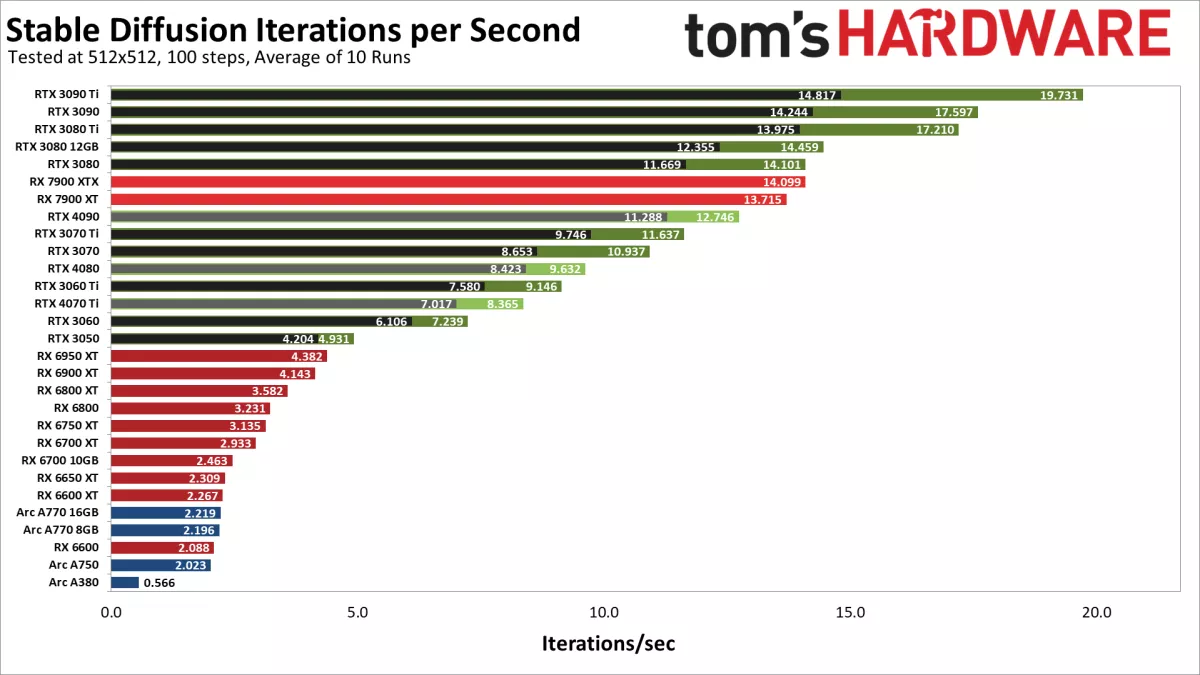

ベンチマーク方法としてはNVIDIA、AMD、Intelで3つの異なるStable Diffusionプロジェクトを使用して計測が行われています。NVIDIAはAutomatic 1111のwebuiバージョン、AMD GPUはNod.aiのSharkバージョン、IntelのArc GPUはStable Diffusion OpenVINOが使われています。

本来であれば1つのパッケージで計測した方が精度の高い安定した結果が確認できますが、誰でも簡単に使える事も重要な指標であることから、3社で使える最も簡単かつ最適化されたプロジェクトが使われています。

モデルに関しては、Stable Diffusion 1.4モデルが使用されています。最新のバージョンは2.1となっていますが、NVIDIA以外のグラフィックスカードで動作しないことから互換性が最も保たれている1.4モデルを使用してのベンチマークになっています。

Stable Diffusionの設定パラメーターについてはすべてのグラフィックスカードで共通で行われています。(詳細はToms Hardwareを参照ください。)

まず、512x512解像度において最も高い反復回数を記録したのはNVIDIAのGeForce RTX 3090 Tiになっています。このテストにおいては上位はRTX 3090 Ti、RTX 3090、RTX 3080 TiなどRTX 3000シリーズが軒並み上位を独占していますが、この結果についてはRTX 4000シリーズへの最適化が行われていない事が原因である可能性があるようです。

ただ、現時点ではRTX 4090はRTX 3090 Tiの65%ほどの性能に留まっており、AMDのRadeon RX 7900 XTXやRX 7900 XTをも下回る性能を記録しています。

AMDにおいては最新のRadon RX 7900 XTXとRX 7900 XTについては性能が比較的高いですが、RX 6000シリーズは全般としてAI処理は得意では無い様で、NVIDIAのエントリーモデル、GeForce RTX 3050をも下回るスコアになっています。

IntelのArcシリーズに関しては最も低いパフォーマンスを示しています。

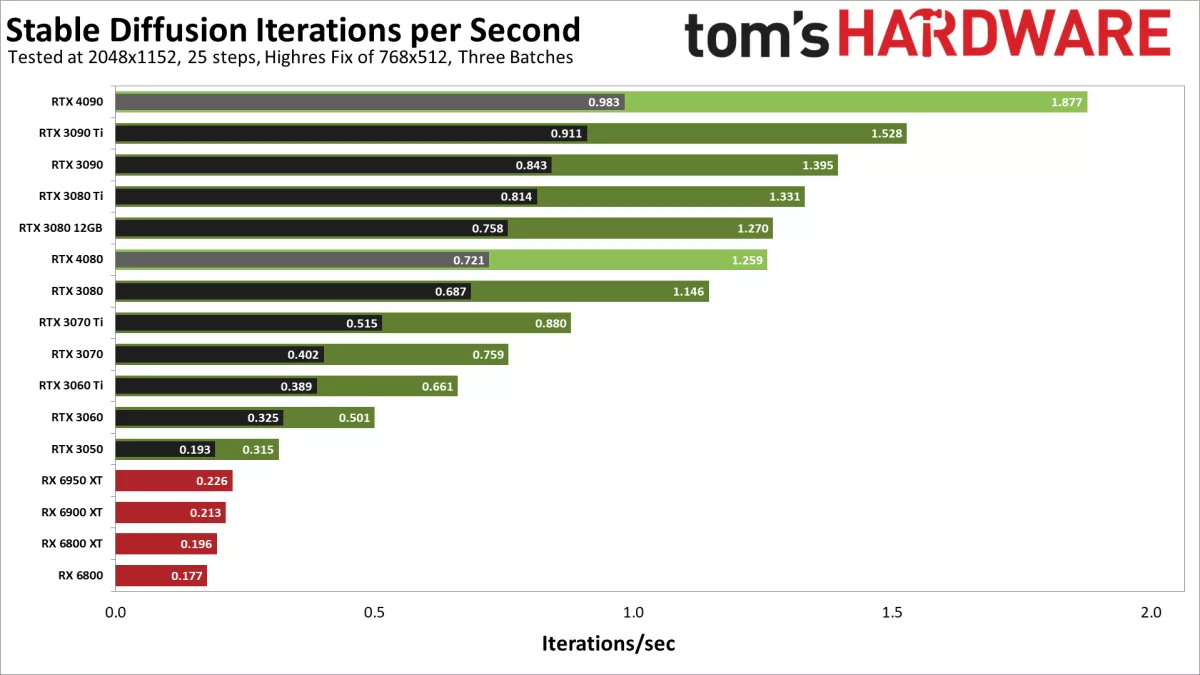

解像度を2048x1152へ上げた場合の結果については512x512と少々異なる結果になっています。最も高い性能を記録したのはRTX 4090となっており、次点でRTX 3090 Ti、3位にRTX 3090となっています。

また、RTX 4000シリーズに関してはRTX 4080がRTX 3080 12GB相当となっており、CUDAコア数や動作クロックの他に、VRAM速度と帯域幅なども関係してくる可能性がありそうです。

Toms Hardwareでは2048x1152解像度でのテストについてはRadeon RX 7900シリーズやRTX 4070 Tiに関してはデータが取り終わっていないとのことですが、これらStable Diffusionの結果についてはソフトウェア側の最適化次第で性能が大きく変わる可能性があるため今後、定期的にベンチマーク結果を更新するとの事です。

これらの結果からStable Diffusionを使用する際にRTX 3090 TiやRTX 3090などハイエンドGPUを既に所有しているのであれば、RTX 4090やRTX 4080へすぐに乗り換えてもより高いパフォーマンスを期待する事は出来ないようです。一方で、RTX 4090やRTX 4080についてはGPU自体の性能はRTX 3090 Tiを上回っているため、将来的にソフトウェア側の最適化が進めば高い性能を発揮するのは明白で、AI向けに新たにハードウェアを新たに購入する場合はRTX 4090などを投入するのも選択肢としてアリと言えそうです。

また、過去にAMD製グラフィックカードについてはAI処理には向かないという印象が強かったのですが、Radeon RX 7900ではRTX 3080並みの性能を記録していますので、ゲームとAI、両方ともバランスよく使いたいという場合にはRadeon RX 7000シリーズも選択肢に入れても良いと言えそうです。

コメント

コメント一覧 (4件)

StableDiffusion1.xは512x512なのでVRAM16GBぐらいでも何とかなりますが、

StableDiffusion2.xは768x768なのでVRAM24GB以上は無いと厳しいですね。

StableDiffusion3.xがリリースされる頃には1024x1024でVRAM32GB以上必要になっているので、

現行のグラボは厳しいでしょうね。

メモリ増設でVRAMを増やせるAPUなら問題無いかもしれませんが・・・

指先等の細かい部分の描画品質が全然違って来るので、学習データの高解像度化はとても効果的ですが、

VRAM消費が盛々増えていくのが難点です。

v2でも12GBあれば動きますよ

通常、学習の精度を落とせばVRAM消費は少なくなりますが、一定以上学習させると精度が足りないのでそれ以上学習させても誤差の範囲に収まってしまい学習が出来なくなります。

学習データそのものの精度が落ちるので出力される物の精度も落ちます。

StableDiffuson1.0と2.0の比較を見ても明らかですね、

例えば、StableDiffusion1.xモデルでは、

画像を学習する時に512x512にリサイズ(縮小)するので、精度が落ちます。

細部が潰れた学習になるので出力時に指先等の細かい部分が崩れます。

細部が崩れてしまい、何度も出力し直している人も多いと思います。

GPUでのAI処理はVRAMが足りない為、精度を落としたりデータの一部をメインメモリに退避させたりしてやり繰りして何とかしているのが現状です。

最適化のコストもタダではないので開発リソースを割かれる原因になります。

この記事でもそうですが、RTX4000シリーズの最適化についても同様です。

(最適化が十分でないだけでRTX4090が遅いわけではない)

tom's の記事が更新されていますね。

現在価格帯の近い3000シリーズ以上の結果が出ているようで、

SDだけではなくゲームも楽しみたいユーザーは

安心して4000シリーズを選べます(^^)