ChatGPTではNVIDIA製グラフィックスカードが処理に使われていますが、このChatGPTの使用頻度増加と用途拡大によってNVIDIA製グラフィックスカードに搭載されているDRAM価格が大きく高騰しているようです。

ChatGPTでNVIDIA製グラフィックスカードの需要が大幅増。DRAM価格が需要増により大幅高騰へ

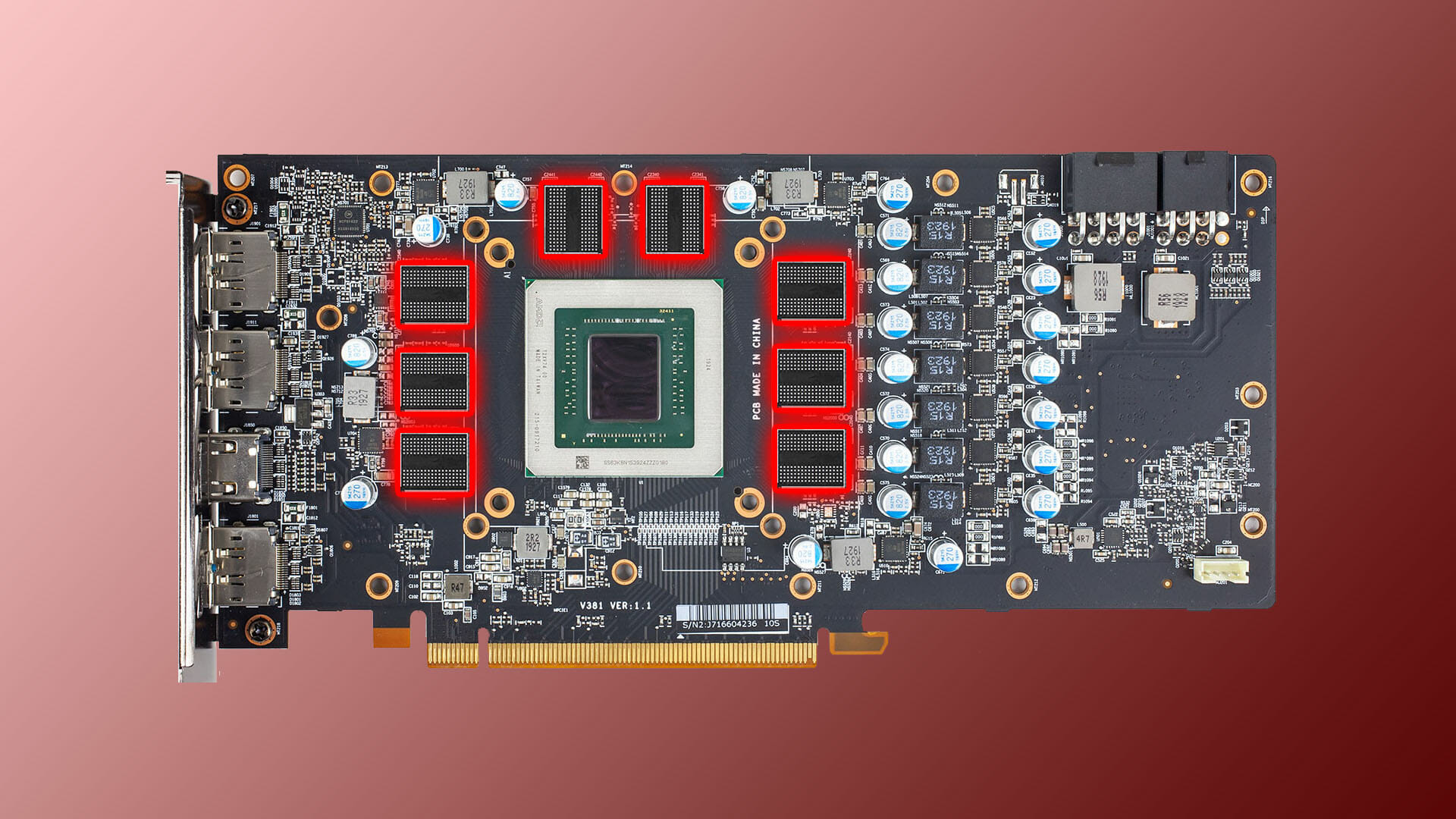

ChatGPTというとたった数週間で100万人のユーザーを獲得するなど人気爆発中のテキスト生成AIですが、最近ではMicrosoftと協業しBingやMicrosoft 365にもChatGPT機能を統合する見通しとなっています。このChatGPTの処理に使われているのがグラフィックスカードで、この中でもNVIDIAがAI用途向けに開発した100シリーズGPUが多様されていますが、これらのグラフィックスカードに搭載されているHBM3やHBM2などの高速VRAMの需要が大きくなっていることで価格が高騰している事が韓国の経済誌、BusinessKoreaより明らかになっています。

人工知能(AI)チャットボット「ChatGPT」の登場は、韓国のメモリー半導体メーカーに新しいビジネスを生み出す機会を提供している。

ChatGTPはAIを通じて多くのデータを学習し、質問に自然に答えてくれる。ChatGPTのサービスをより良く、より速くするためには、DRAMのデータ処理速度が重要になっている。そのために不可欠な高性能DRAMを韓国企業はこぞって生産しています。

世界最大のGPU企業であるNVIDIAは、SK Hynixの最新製品であるHBM3チップの供給を要請している。サーバー向けCPUを製造するIntelもSK HynixのHBM3を搭載した製品の販売に力を注いでいる。業界関係者はこのHBM3価格は最大5倍に上昇したとのことです。

HBM3は現在、SK Hynixが製造を行っており、2022年に発売がされたHopper H100では最大80GBのHBM3が搭載されています。このHBM3はAI動作の高速化や高機能化には必要不可欠な機能にはなっているのですが、このHBM3の需要は大きく、NVIDIAだけではなくIntelもサーバー向けCPUのSapphire RapidsにHBM3を搭載した製品の販売を強化しているようです。このようにHBM3への高い需要が原因となり、HBM3価格は最大5倍にまで高騰しているとのことです。

BusinessKoreaではHBM3の価格にのみ言及されていますが、HBM3より古いHBM2やHBMについてもAI用途に使うには十分な性能を有しており、HBM2についてはAmpere A100などにも搭載されておりまだまだ現役で使えるものになっています。そのため、HBM3のみならずHBM2などその他HBMの価格も大きく高騰しているものと考えられています。なお、このHBMについてはSK Hynixが60~70%のシェアを握っており、代替先もすぐには見つからないためHBM系を搭載する製品については価格高騰が割けられない見通しと言えます。

ChatGPTのような生成系AIには大容量かつ高速なメモリーが必要不可欠となっており、NVIDIAのHopper A100やAmpere A100がAI用途には最適なGPUになっています。ChatGPTを使った事がある方であれば一度は「順番待ち」状態に遭遇したことはあると思いますが、アクティブユーザーが1億人を超えるなど爆発的な人気を支えるにはこれらのグラフィックスカードが必要不可欠なのですが、HBM3の価格が5倍にも達しているのを見ると需要が多すぎて供給が明らかに追いついていない状態になっていると言えます。

ChatGPTなどがMicrosoft製品の様々な機能へ統合されていく予定であるのは明らかですが、この統合スケジュールの大多数はAI開発というよりはAIに対応したハードウェアの準備に依存すると言えそうです。

コメント

コメント一覧 (3件)

最強GoogleのBardがリリースされるまでのバブルですかね

Google製のAIチップであるTPUはHBM搭載

そしてGoogle自身も自社チップに加えてnVidiaのGPUを大量に使用している

GoogleがAIを強化すればするほどHBMの需要はさらに逼迫するんだけどバブルって?

仮想通貨需要減がやっと落ち着いたら今度はAIbotかよ