ChatGPTをはじめとするAIの動作にはNVIDIA製GPUが活用される場合が多くありますが、このChatGPTを開発するOpenAIがChatGPTなどのサービス利用者数の増加や更なる機能向上に向けてNVIDIA製GPUを3万台以上投入する事が予測されているようです。

ChatGPTのOpenAIがNVIDIA製GPUを3万台程度投入へ。NVIDIAがエンタープライズ向けGPUを主力にシフトさせる可能性

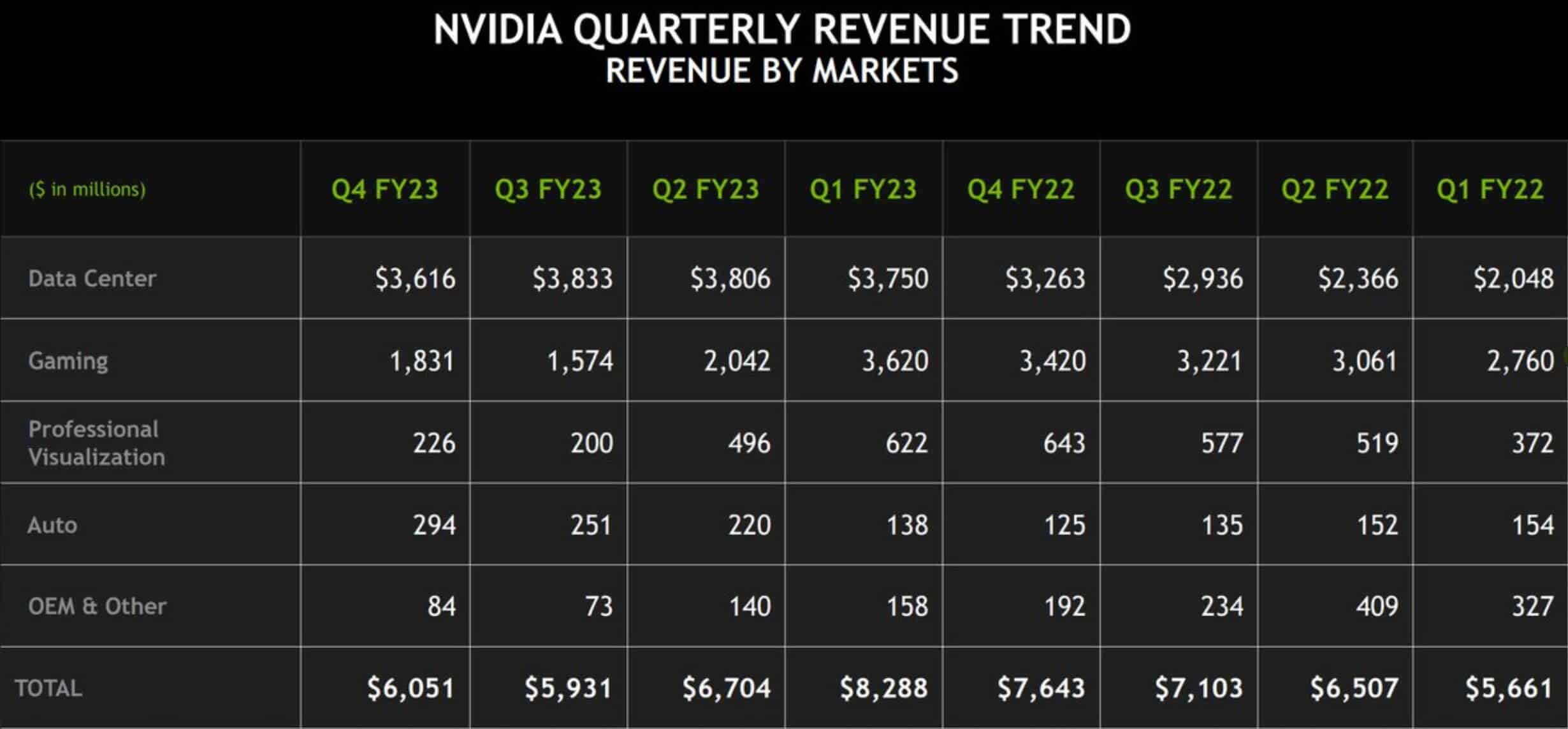

NVIDIAでは企業収益の多くはゲーミング用のグラフィックカードであるGeForceなどから来ていましたが、値上げやインフレ、需要の先食いによって最新の決算発表では前年同期比で46%減となりました。一方で、この大幅減少に対して、データセンター向けGPUの売上高は安定かつ伸びを見せていますが、今後さらにこのデータセンター向けGPUの収益が伸びる可能性があるようです。

調査会社TrendForceによると、AI分野向けのGPUがNVIDIAの今後の収益の柱になると予測しており、AIを活用したChatGPTで一気に知名度を伸ばしたOpenAIは3万枚以上のNVIDIA製GPUを投入するとのことです。

NVIDIAのAmpere A100 GPUの性能をベースに考えるとChatGPTがトレーニング用データを処理するために約2万台分必要なのですが、今後GPT4などより高機能化されたモデルを活用するなど新機能を展開するには更に大量のGPUが必要となる可能性があるとのことです。

Ampere A100については価格や構成、形状によって1台辺り130万円~180万円の価格になっていますが、これらをOpenAI社が3万台投入するとなると、これだけでNVIDIAには約390億円の売上を記録する事が可能になります。

NVIDIAではこのAmpere A100の後継モデルのHopper H100 GPUの出荷も開始しており、A100に比べて約3倍のパフォーマンスを発揮するGPUとなっており、AIトレーニングにおいては最大9倍のスループットを実現しています。そのため、OpenAIが今後Microsoftとの協業を拡大し、ユーザー数の拡大とGPT-4などコンテクスト量が増えた学習データを使うためにHopper H100などより高性能なGPUの投入を行う可能性もあります。ただ、このHopper H100はA100に比べると価格は3倍に上がっており、1台辺り430万円となっています。

このAI向けに使われるGPUについてはNVIDIAはかなり期待を抱いているようで、最新の決算発表の場ではNVIDIA CEOのJensen氏はゲーミング用GPUの売上高が下がっても、AI向けにデータセンター向けGPUが売れるという予測を立てており、今後ChatGPTやBing AIに加え、GoogleやFacebookもAI分野に参入している事から、NVIDIAはこのAIなどに使われるデータセンター向けGPUを軸足とした経営を行う可能性が高いと言えそうです。

なお、AI分野向けにGPUが大量に使われるとゲーミング向けのGPUであるGeForceに影響が心配されますが、Ampere A100に関してはGeForce RTX 3000シリーズとは異なるファウンドリーを使っていたためあまり影響はありませんが、Hopper H100に関してはGeForce RTX 4000シリーズと同じTSMC N4(5nm)を使っていますが、現時点でTSMC 5nmのキャパシティーが不足している話は出ていないため影響は無いと見られています。

ただ、心配されるのはRTX 5000など未来です。NVIDIAがAI向けのデータセンター向けGPUへ軸足を本格的に移すとGeForce RTX 5000やRTX 6000など次世代モデルに関してはNVIDIAは競争力をあまり意識しなくなる可能性があります。特に2023年内もゲーミング向けGPUの売上高が低調となれば性能の伸びが停滞したり、最悪な場合はデータセンター向けGPUとして活用できるハイエンドモデルのみ発売し、エントリーモデルは発売しないなども考えられるため、AIがNVIDIAの成長ドライバーとなりリソースのほとんどを注ぎ込む事になると将来的にはゲーミング向けグラフィックスカードへの影響も避けられないかもしれません。

コメント

コメント一覧 (1件)

GPUがNVIDIA依存だと

自前で大規模なデータ、TPUが調達できるGoogleとの競争は無理ゲーな感じですねw